Series de tiempo

Contents

from bccr import SW

import numpy as np

import matplotlib.pyplot as plt

plt.style.use('seaborn')

import pandas as pd

import statsmodels.api as sm

1.5. Series de tiempo#

Definición de serie de tiempo#

Una serie de tiempo es una colección de observaciones indexadas por la fecha de cada observación, denotada por \(y_t\)

En la práctica se asume que lo anterior es sólo una muestra, pero que la serie pudo haber sido observada en más períodos.

Así, vemos a una serie de tiempo como una realización del proceso estocástico \(\{Y_t\}^\infty_{t=-\infty}\), de la cual solo tenemos observaciones para \(t\) entre 1 y \(T\).

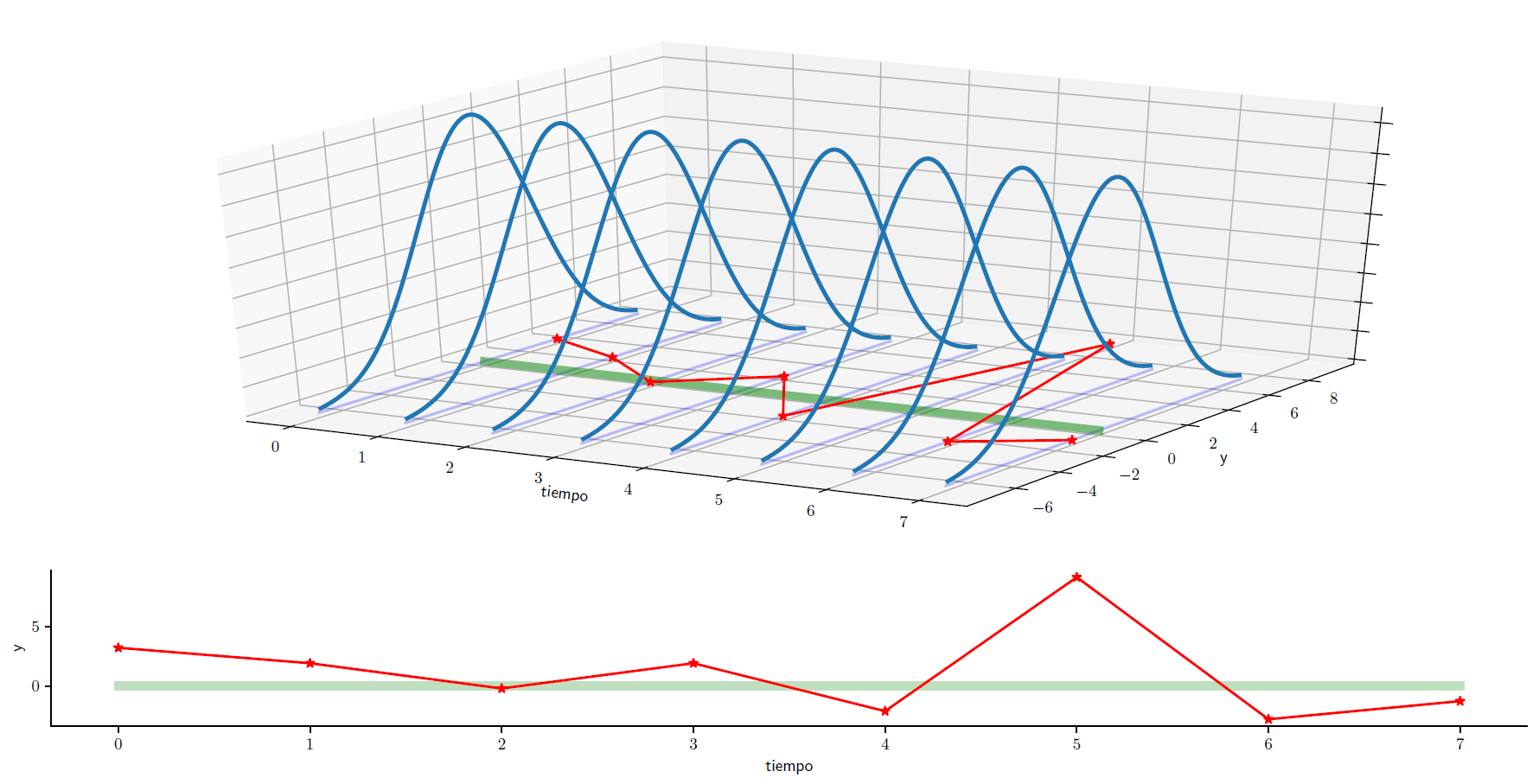

Serie de tiempo estacionaria#

Una serie de tiempo estacionaria es una realización de un proceso estocástico estacionario.

Fig. 1.5 Una serie estacionaria#

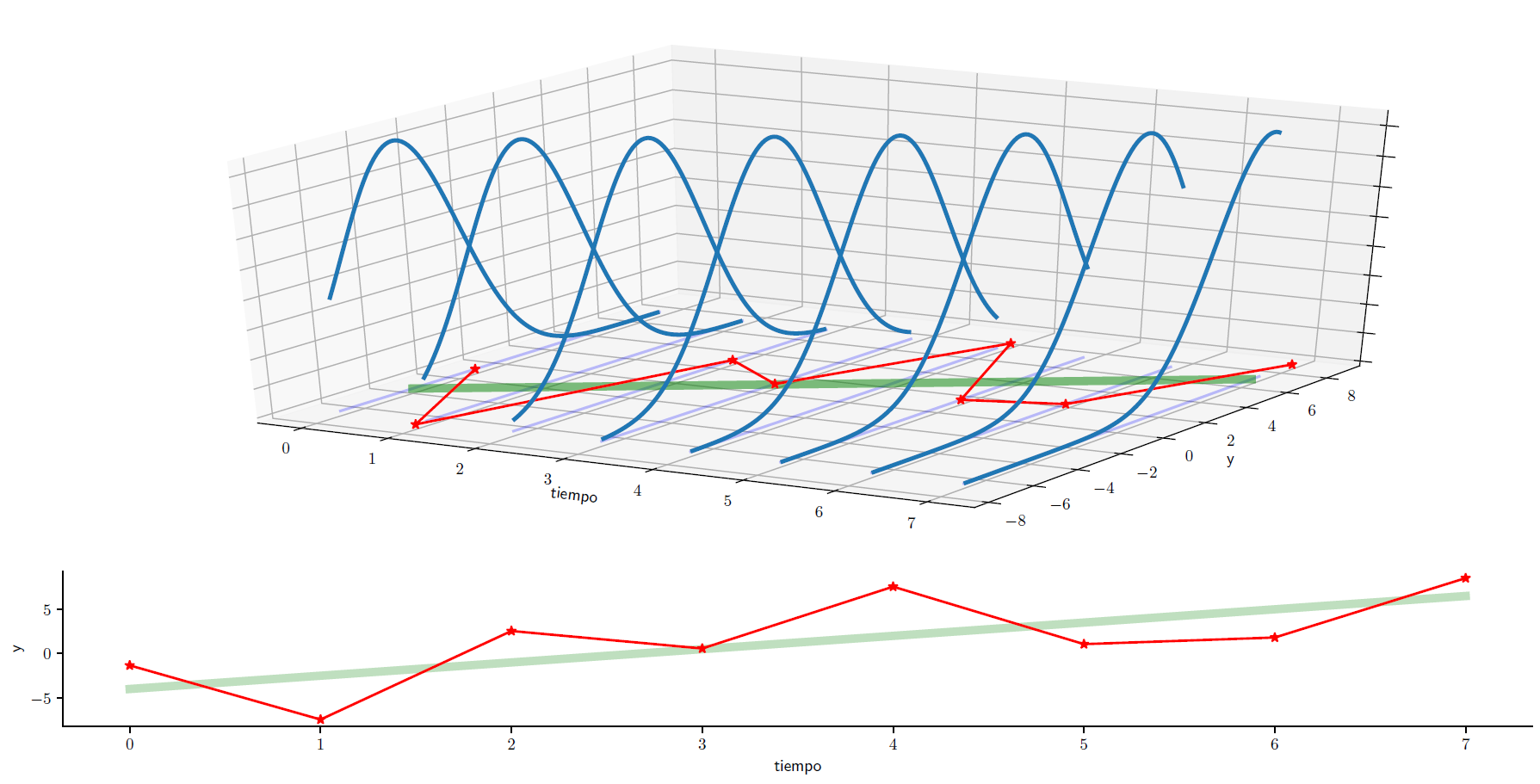

Serie de tiempo no estacionaria#

Una serie de tiempo no estacionaria es una realización de un proceso estocástico no estacionario.

Fig. 1.6 Una serie no estacionaria#

Casos particulares de series de tiempo#

Infiriendo los momentos del proceso estocástico#

Suponga que tenemos un número grande \(n\) de realizaciones independientes del proceso estocástico \(\{Y_t\}^T_{t=1}\), y que deseamos estimar el valor del momento no central \(\mu'_{k,t} \equiv \E[Y^k_t]\). Utilizando la ley de los grandes números, podemos estimarlo así

En la práctica, sólo tenemos una única realización del proceso: \(y_1, y_2, \dots, y_T\).

¿Podemos estimar \(\mu'_{k,t}\) a partir de \(\overline{y^k} = \frac{y^k_{1} + y^k_{2} + \dots y^k_{T}}{T}\)? En general no, a menos que el proceso estocástico sea

estacionario

ergódico (para el momento \(k\)).

Ergodicidad#

En el caso de procesos estacionarios, el supuesto de ergodicidad significa que momentos muestrales calculados a partir de una serie de tiempo con un número finito de observaciones converge (en algún sentido) a sus contrapartes poblacionales.

El proceso es ergódico en media si

El proceso es ergódico en varianza si

Algunas apuntes acerca de la ergodicidad#

Las condiciones de ergodicidad son “propiedades de consistencia” para variables aleatorias dependientes, y no pueden ser evaluadas. Por ello, deben ser asumidas.

No podemos usar la ley de los grandes números para probar ergodicidad, porque las distribuciones de distintos momentos \(t\) pueden ser idénticas, pero en general no son independientes.

Un proceso no estacionario no puede ser ergódico: ¿a los momentos de cuál variable \(Y_t\) convergerían los momentos muestrales si los poblacionales no fueran constantes?

Estimación de momentos de un proceso estacionario#

Si el proceso es ergódico, podemos estimar consistentemente:

Autocorrelación#

Es imposible evaluar qué tan fuerte es la dependencia de variables de un proceso estocástico a partir de las autocovarianzas, porque éstas dependen de las unidades de medida de la serie. Por ello, utilizamos las autocorrelaciones, que se obtienen de dividir las autocovarinzas por la varianza del proceso.

Si el proceso es estacionario se cumple que:

\(\rho_0 = 1\)

\(\rho_\tau = \rho_{-\tau}\)

\(\left|\rho_\tau\right|\leq 1\) para todo \(\tau\).

LLamamos autocorrelograma a la secuencia de autocorrelaciones \(\rho_\tau\), vista como función del número de rezagos \(\tau\).

Autocorrelación muestral#

En la práctica, a partir de una muestra estimaremos la autocorrelación muestral.

Como nuestra muestra es finita, los valores estimados no necesariamente coincidirán con los poblacionales. Por ello, nos interesa especialmente saber cuándo estas autocorrelaciones son significativamente distintas de cero. Según Bartlett (1946), la varianza de los coeficientes de autocorrelación en los cuales \(\rho_{k+1}, \rho_{k+2}, \dots = 0\) está dada por

Autocorrelación parcial#

La \(m\)-ésima autocorrelación parcial \(\hat{a}_m^{(m)}\) se estima por OLS como el último coeficiente de una regresión de \(y\) en una constante y sus \(m\) valores más recientes:

La idea es medir el efecto directo de, por ejemplo, \(y_{t-1}\) sobre \(y_{t+1}\), controlando por el efecto indirecto que \(y_{t-1}\) pueda tener sobre \(y_{t+1}\) a través de \(y_{t}\).

Si los datos están generados por un proceso AR(p), entonces el estimador \(\hat{a}_m^{(m)}\) tiene una varianza alrededor del verdadero valor (cero) aproximada por

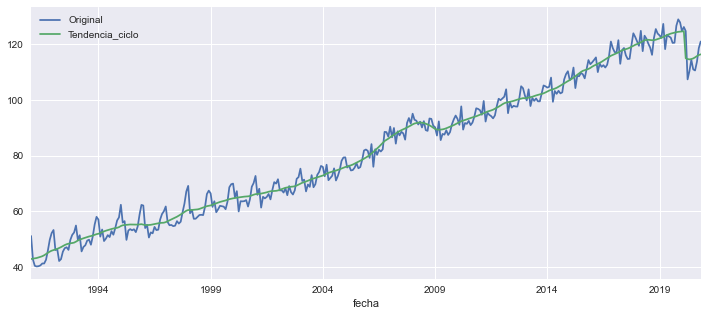

Obtenemos y graficamos los datos

imae = SW(Original=35449, Tendencia_ciclo=35553)

imae.plot(figsize=[12,5]);

plot_acf = sm.graphics.tsa.plot_acf

plot_pacf = sm.graphics.tsa.plot_pacf

log_imae = np.log(imae)

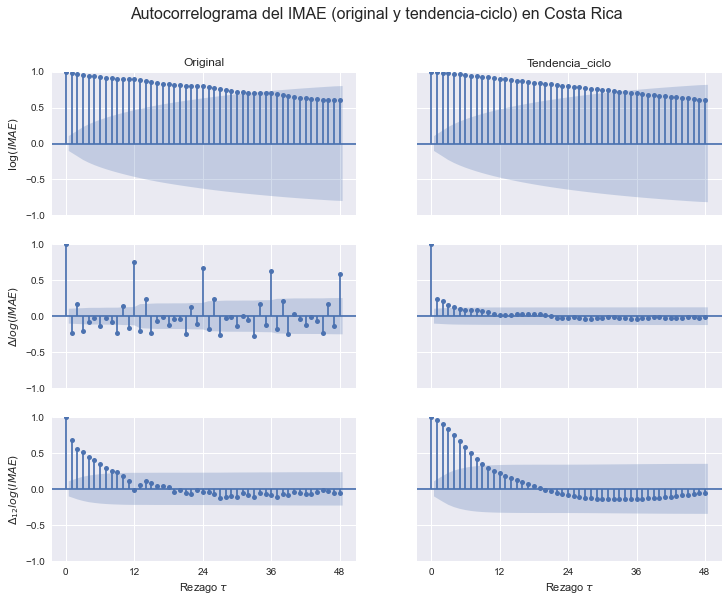

Hacemos los autocorrelogramas

OPCIONES = dict(lags=48, alpha=0.05, title='')

fig, axs = plt.subplots(3,2, figsize=[12,9], sharex=True, sharey=True)

for indic, ax in zip(imae, axs.T):

plot_acf(log_imae[indic].dropna(), ax=ax[0], **OPCIONES);

plot_acf(log_imae[indic].diff().dropna(), ax=ax[1], **OPCIONES);

plot_acf(log_imae[indic].diff(12).dropna(), ax=ax[2], **OPCIONES);

for indic, ax in zip(imae, axs[0]):

ax.set_title(indic)

for ax in axs[-1]:

ax.set_xlabel(r'Rezago $\tau$')

ax.set_xticks(np.arange(0,49,12));

axs[0,0].set_ylabel(r'$\log(IMAE)$')

axs[1,0].set_ylabel(r'$\Delta log(IMAE)$')

axs[2,0].set_ylabel(r'$\Delta_{12} log(IMAE)$')

fig.suptitle('Autocorrelograma del IMAE (original y tendencia-ciclo) en Costa Rica', size=16);

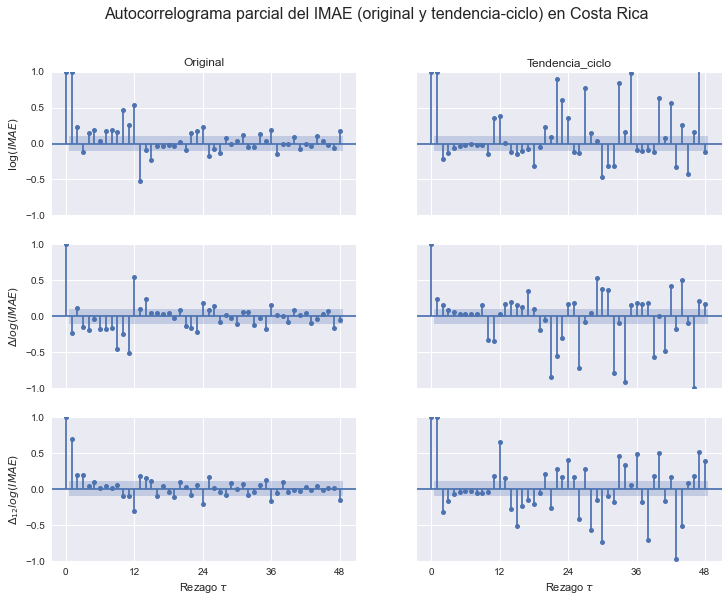

Hacemos los autocorrelogramas parciales

OPCIONES = dict(lags=48, alpha=0.05, title='', method='ols')

fig, axs = plt.subplots(3,2, figsize=[12,9], sharex=True, sharey=True)

for indic, ax in zip(imae, axs.T):

plot_pacf(log_imae[indic].dropna(), ax=ax[0], **OPCIONES);

plot_pacf(log_imae[indic].diff().dropna(), ax=ax[1], **OPCIONES);

plot_pacf(log_imae[indic].diff(12).dropna(), ax=ax[2], **OPCIONES);

for indic, ax in zip(imae, axs[0]):

ax.set_title(indic)

for ax in axs[-1]:

ax.set_xlabel(r'Rezago $\tau$')

ax.set_xticks(np.arange(0,49,12));

axs[0,0].set_ylabel(r'$\log(IMAE)$')

axs[1,0].set_ylabel(r'$\Delta log(IMAE)$')

axs[2,0].set_ylabel(r'$\Delta_{12} log(IMAE)$')

fig.suptitle('Autocorrelograma parcial del IMAE (original y tendencia-ciclo) en Costa Rica', size=16);