Modelos de series con tendencia

Contents

import bccr

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

import statsmodels.api as sm

plt.style.use('seaborn')

4.1. Modelos de series con tendencia#

Series integradas#

A las series que tienen tendencia se les conoces como series integradas. ¿Pero por qué integradas?

Supongamos por un momento que \(y(t)\) es una variable cuyo valor depende del momento \(t\) (continuo) en que se observa. Supongamos también que \(y\) cambia a una tasa constante \(a\) y que su valor inicial es \(y(0)\). ¿A qué es igual \(y(t)\)?

De los supuestos anteriores:

integrando ambos lados

por lo tanto

Supongamos ahora que el tiempo se mide en unidades discretas, que el valor inicial es \(y_0\) y que la variable crece una cantidad fija \(a\) cada período. Entonces

integrando ambos lados

por lo tanto

Este resultado lo podemos obtener de manera equivalente con el operador de rezagos:

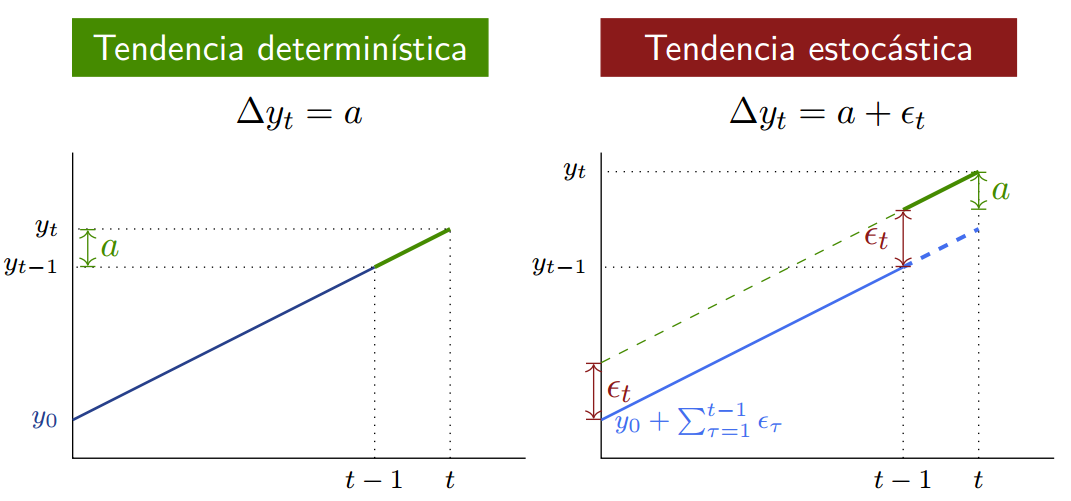

Vemos que si \(\Delta y_t = a\), es decir, la serie \textbf{cambia una cantidad fija} \(a\) cada período, entonces \(y_t = y_0 + at \) tiene una tendencia determinística.

Supongamos en contraposición que el valor esperado del cambio es constante, en particular

donde \(\epsilon_{\tau}\) es ruido blanco.

Entonces, integrando

Decimos que la serie tiene una tendencia estocástica.

Tendencias determinísticas versus estocásticas#

Tendencias cuadráticas#

Es sencillo generalizar el procedimiento para obtener tendencias cuadráticas.

Si el cambio en la serie es lineal en vez de constante:

Es fácil de mostrar que si el cambio es aleatorio \(\Delta y_\tau = a + b\tau + \epsilon_{\tau}\) entonces

Serie estacionaria alrededor de una tendencia (TS)#

Supongamos que \(\omega_t=A(\Lag)\epsilon_t\) es una serie estacionaria, tal que

Definimos una serie

estacionaria alrededor de una tendencia

Vemos que

Por otra parte, su autocovarianza es:

Es decir, la media de \(y_t\) no es estacionaria (porque depende de \(t\)), pero su varianza-covarianza sí es estacionaria (idéntica a la del proceso \(\omega_t\)).

Por ello, el correlograma de un proceso estacionario alrededor de una tendencia es similar al correlograma de un proceso estacionario.

Caminata aleatoria#

El proceso de caminata aleatoria es muy utilizado en la teoría económica y financiera, en especial en la formulación de la hipótesis de mercado eficiente.

Definimos la serie

caminata aleatoria

Integrando el proceso sabemos que

o bien, si deseamos expresar \(y_{t+s}\) en función en \(y_t\)

Consideremos \(y_0\) como dado, y calculemos los momentos condicionales de la caminata aleatoria:

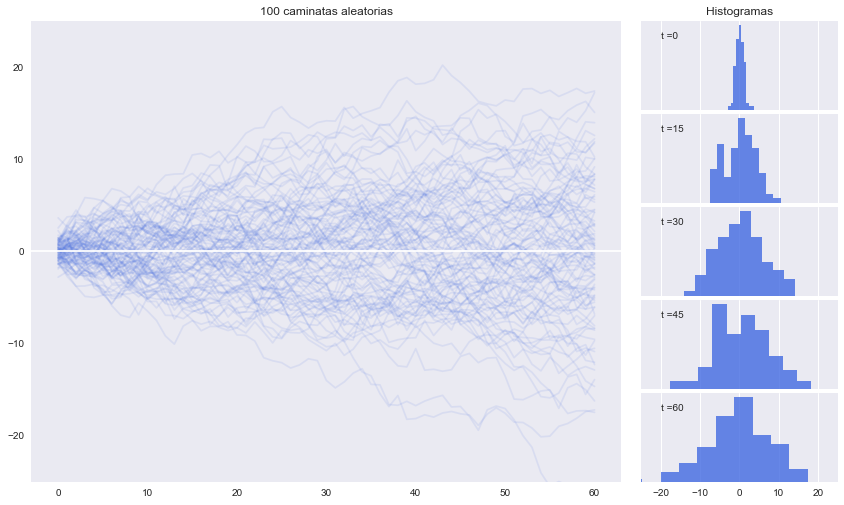

partiendo de \(y_{-1}=0\) y asuminedo \(\epsilon \sim N(0,1)\).

plt.style.use('seaborn-dark')

np.random.seed(2021)

T = 60 # horizonte

n = 100 # cantidad de simulaciones

𝜖 = pd.DataFrame(np.random.randn(T+1, n)) # ruido blanco

y = 𝜖.cumsum(axis=0) # caminatas aleatorias

fig = plt.figure(figsize=(14, 8))

gs = fig.add_gridspec(5, 2, width_ratios=(6, 2),

left=0.1, right=0.9, bottom=0.1, top=0.9,

wspace=0.05, hspace=0.05)

# -----------Graficar las simulaciones

ax = fig.add_subplot(gs[:, 0])

y.plot(color='RoyalBlue', alpha=0.1, legend=False, ax=ax)

ax.axhline(0, color='white');

ax.set(title=f'{n} caminatas aleatorias',ylim=[-25,25])

# -----------Histogramas

ax_last = None

for i in range(5):

ax_last = fig.add_subplot(gs[i, 1], sharex= ax_last)

y.loc[15*i].hist(ax=ax_last, color='RoyalBlue', alpha=0.8)

if i==0:

ax_last.set(title='Histogramas',xlim=[-25,25])

ax_last.set_yticks([])

ax_last.annotate(f't ={15*i}', (0.1, 0.8), xycoords='axes fraction')

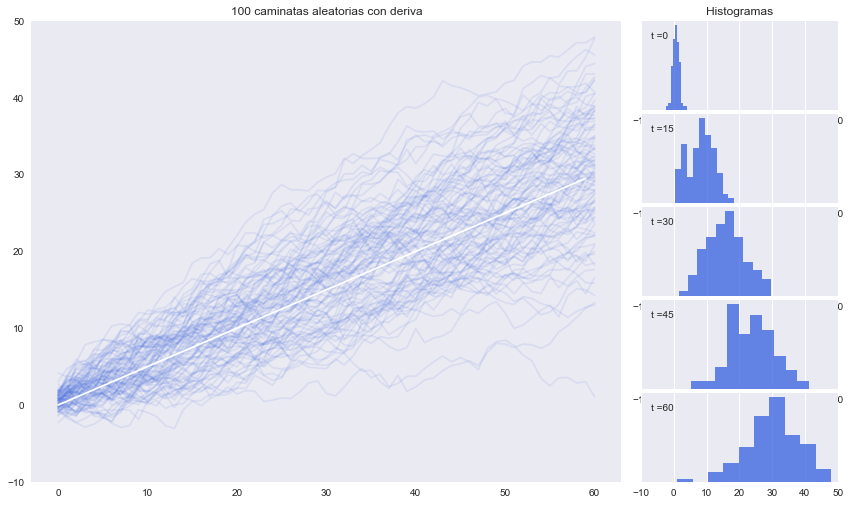

Caminata aleatoria con deriva#

El proceso de caminata aleatoria con deriva es similar a la caminata aleatoria: \vspace{0.5em}

caminata aleatoria con deriva

Integrando el proceso sabemos que

Vemos que la caminata aleatoria con deriva le añade una tendencia lineal determinística \(at\) a la caminata aleatoria convencional \(y_0 +\sum_{\tau=1}^s \epsilon_{t+\tau}\)

Este es un ejemplo de un modelo de tendencia puro: no tiene un componente estacionario.

Sabemos que añadir un componente determinístico a una variable aleatoria cambia su media en la misma magnitud de ese componente, pero no alterna su varianza. Entonces, para la caminata aleatoria con deriva:

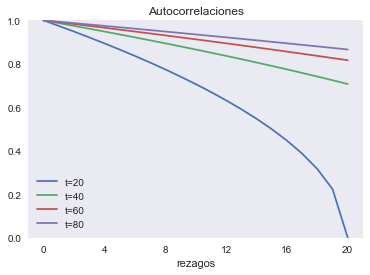

def rw_rho(t, smax=20):

"""

Calcula las primera autocorrelaciones de una serie con raiz unitaria

"""

return np.sqrt(1 - np.arange(smax+1) /t)

rw_rho_data = pd.DataFrame({f't={t}':rw_rho(t) for t in [20,40,60,80]})

fig, ax = plt.subplots()

rw_rho_data.plot(ax=ax)

ax.set(ylim=[0,1], xticks=np.arange(0,21,4), xlabel='rezagos', title='Autocorrelaciones');

partiendo de \(y_{-1}=0\) y asuminedo \(\epsilon \sim N(0,1)\).

a = 0.5 # deriva

y = (𝜖+a).cumsum(axis=0) # caminatas aleatorias con deriva

fig = plt.figure(figsize=(14, 8))

gs = fig.add_gridspec(5, 2, width_ratios=(6, 2),

left=0.1, right=0.9, bottom=0.1, top=0.9,

wspace=0.05, hspace=0.05)

ax = fig.add_subplot(gs[:, 0])

y.plot(color='RoyalBlue', alpha=0.1, legend=False, ax=ax)

ax.plot(a*np.arange(T), color='white');

ax.set(title=f'{n} caminatas aleatorias con deriva',ylim=[-10,50])

ax_last = None

for i in range(5):

ax_last = fig.add_subplot(gs[i, 1], sharex= ax_last)

y.loc[15*i].hist(ax=ax_last, color='RoyalBlue', alpha=0.8)

if i==0:

ax_last.set(title='Histogramas',xlim=[-10,50])

ax_last.set_yticks([])

ax_last.annotate(f't ={15*i}', (0.05, 0.8), xycoords='axes fraction')

Pronosticando una caminata aleatoria#

Es sumamente difícil pronosticar una caminata aleatoria. Supongamos que tenemos datos hasta \(t\) y deseamos pronostica el valor de la serie en \(t+k\). En este caso:

Es decir, el mejor pronostico para cualquier valor futuro de la serie es su valor observado más reciente.

Pero la varianza de este pronóstico crece linealmente, resultando infinitamente grande conforme \(k\to\infty\).

Series estacionarias en diferencia (DS)#

Las caminatas aleatorias (con o sin deriva) son ejemplos de series {estacionarias en diferencia.

Esto quiere decir que si tomamos su primera diferencia, el resultado es una serie estacionaria:

Por ello, decimos que la serie \(y_t\) es **integrada de orden 1.

En general, si una serie \(z_t\) debe ser diferenciada \(d\) veces para obtener una serie estacionaria, entonces decimos que \(z_t\) es integrada de orden \(d\), escrito \(I(d)\).

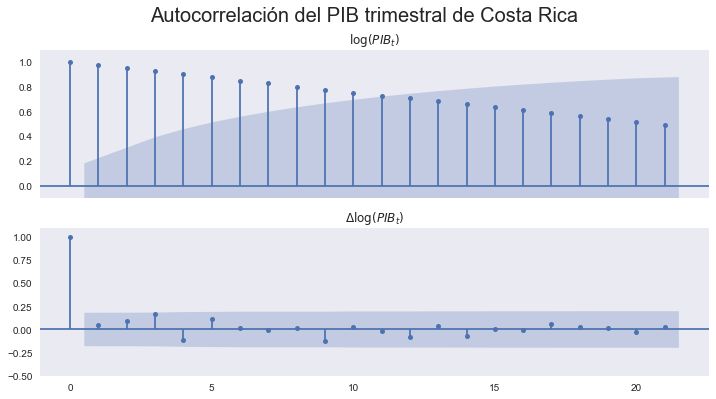

pib = bccr.SW(PIB=33783)

pib['lPIB'] = np.log(pib['PIB'])

fig,axs = plt.subplots(2,1, sharex=True, figsize=[12,6])

sm.graphics.tsa.plot_acf(pib['lPIB'],ax=axs[0]);

axs[0].set(ylim=[-0.1,1.1], title='$\log(PIB_t)$')

sm.graphics.tsa.plot_acf(pib['lPIB'].diff().dropna(),ax=axs[1]);

axs[1].set(ylim=[-0.5,1.1], title='$\Delta\log(PIB_t)$')

fig.suptitle('Autocorrelación del PIB trimestral de Costa Rica', fontsize=20);